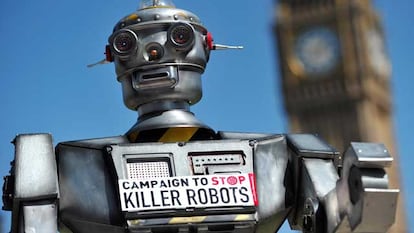

Cientistas contra robôs armados

Cerca de 1.000 especialistas em inteligência artificial criticam as armas autônomas porque estas não possuem critérios éticos

A inteligência artificial está atingindo um desenvolvimento tão intenso que inquieta até seus pesquisadores pelo uso indevido que se pode fazer dela. Mais de 1.000 cientistas e especialistas em inteligência artificial e outras tecnologias assinaram uma carta aberta contra o desenvolvimento de robôs militares autônomos, que prescindam da intervenção humana para seu funcionamento. O físico Stephen Hawking, o cofundador da Apple Steve Wozniak, e o do PayPal, Elon Musk, estão entre os signatários do texto, que foi apresentado na terça-feira em Buenos Aires, na Conferência Internacional de Inteligência Artificial, um congresso onde estão sendo apresentados mais de 500 trabalhos dessa especialidade e ao qual comparecem vários signatários do manifesto.

O documento não se refere aos drones nem aos mísseis comandados por humanos, mas a armas autônomas que dentro de poucos anos a tecnologia de inteligência artificial poderá desenvolver e isso significaria uma “terceira revolução nas guerras, depois da pólvora e das armas nucleares”.

Especialistas reconhecem que existem argumentos a favor dos robôs militares, como o fato de que reduziriam as perdas humanas em conflitos bélicos. Ao contrário das armas nucleares, as autônomas não apresentam custos elevados e nem requerem matérias-primas difíceis de obter para sua construção, de acordo com os signatários. Por isso eles advertem que é “apenas uma questão de tempo” para que essa tecnologia apareça no “mercado negro e nas mãos de terroristas, ditadores e senhores da guerra”.

“Elas são ideais para assassinatos, desestabilização de nações, subjugação de populações e crimes seletivos de determinadas etnias”, alertam os cientistas, que propõem que a inteligência artificial seja usada para proteger seres humanos, especialmente civis, nos campos de batalha. “Começar uma carreira militar nas armas de inteligência artificial é uma má ideia”, advertem. Os cientistas comparam essa tecnologia com as bombas químicas ou biológicas.

“Não se trata de limitar a inteligência artificial, mas de introduzir limites éticos nos robôs, torná-los capazes de viver em sociedade e, sim, rejeitar claramente as armas autônomas sem controle humano”, explica Francesca Rossi, presidenta da conferência internacional e uma das signatárias do texto. “Com a carta queremos tranquilizar as pessoas que a partir de fora deste mundo olham a inteligência artificial com uma preocupação às vezes exagerada. Nós também estamos interessados em limites éticos. Queremos reunir não apenas especialistas no assunto, mas filósofos e psicólogos para conseguir impor limites éticos aos robôs semelhantes aos dos seres humanos”, enfatiza.

O perigo de reprogramar

O argentino Guillermo Simari, da Universidade Nacional del Sur, organizador do congresso, compartilha da filosofia da carta. “As máquinas podem tomar decisões com as quais o ser humano não está de acordo. Os homens têm filtros éticos. É possível programar um filtro ético para a máquina, mas é muito fácil removê-lo”. Simari acredita que o grande problema é a facilidade com que se pode reprogramar uma máquina. “Para fazer uma bomba atômica é preciso urânio enriquecido, que é muito difícil de conseguir. Para reprogramar uma máquina militar basta alguém com um computador digitando programas”.

No congresso também estão presentes aqueles que são contra a filosofia da carta. “Estão aqui os que acreditam que devemos continuar desenvolvendo a inteligência artificial e que ela pode ser controlada”, diz Ricardo Rodríguez, professor da Universidade de Buenos Aires e organizador do encontro. O debate entre os cientistas está vivo e agora passará para toda a sociedade.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.