Nova revisão invalida milhares de estudos sobre o cérebro

Falha de informática e más práticas generalizadas põem em questão 15 anos de pesquisas

Imagine que o Word da Microsoft, um dos editores de texto mais populares do mundo, contivesse uma falha de programação que gerasse uma letra onde os usuários teclassem espaço. Suponha, também, que alguns digitadores estejam escrevendo às cegas, sem revisar aquilo que digitam. E que passaram 15 anos produzindo documentos com erratas e falsas letras ali onde deveria haver um espaço em branco. Isso foi o que aconteceu durante muitos anos na pesquisa sobre a atividade cerebral. Uma falha no software que lê as ressonâncias magnéticas da massa cinzenta põe em questão milhares de trabalhos científicos realizados neste século. Porque, além disso, segundo uma pesquisa que acaba de ser divulgada, muitos pesquisadores não foram rigorosos revisando e corrigindo seus resultados em busca de manchas.

Esperava-se em torno de 5% de falsos positivos, mas, em alguns casos, encontraram-se 70% de situações em qu8e o programa iluminava uma região onde não acontecia nada

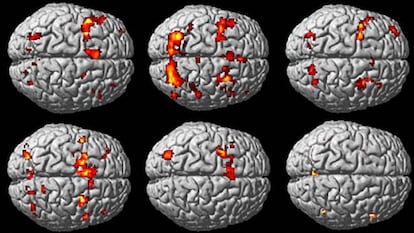

A imagem por ressonância magnética (fMRI, na sigla em inglês) é o método mais amplamente utilizado para estudar o esforço que realizada uma determinada região do cérebro à qual se designa uma tarefa. A fMRI detecta quais zonas estão requerendo mais energia do fluxo sanguíneo graças ao oxigênio que ele transporta. O resultado são aqueles mapas em 3D da massa cinzenta com algumas áreas iluminadas. E os cientistas nos dizem: esta é a parte da sua cabeça que se ativa quando você come chocolate, quando pensa em Donald Trump, quando assiste a filmes tristes etc.

Agora, uma equipe de cientistas liderada por Anders Eklund revelou que muitas dessas zonas foram iluminadas por erro, por causa de uma falha do software e o pouco rigor de alguns de seus colegas. Em seu estudo, publicado na PNAS, eles reuniram 500 imagens do cérebro em repouso, que são as utilizadas como ponto de partida para ver se, a partir daí, o cérebro faz alguma coisa. Usaram os programas mais comuns para fazer três milhões de leituras desses cérebros em repouso. Esperavam encontrar 5% de falsos positivos, mas, em alguns casos, dependendo dos parâmetros adotados, eles se depararam com até 70% de situações em que o programa iluminava uma área onde nada acontecia.

Este estudo foi como o caso do menino que grita que o imperador está nu: já fora denunciado que algumas dessas ressonâncias carecem de base estatística e que estavam sendo supervalorizadas

Esses programas dividem o cérebro humano em 100.000 voxels, que são como os pixels de uma fotografia na sua versão tridimensional. O software interpreta os sinais da ressonância magnética e aponta em quais haveria uma atividade, a partir de um ponto que, em muitos casos, foi menos preciso do que deveria, propiciando falsos positivos. Além disso, os autores da revisão analisaram 241 estudos e descobriram que em 40% deles não foram aplicadas as correções de software necessárias para dar garantias, agravando o problema dos falsos positivos.

O rebuliço adquiriu maiores proporções no campo da neuroimagem, embora ainda se esteja relativizando a dimensão do problema. Inicialmente, Eklund e sua equipe questionavam a validade de cerca de 40.000 estudos. Agora, anunciaram uma correção: Thomas Nichols, outro autor do estudo, estima que apenas cerca de 3.500 trabalhos estariam prejudicados. Mas é impossível saber precisamente quais ou quantos eles são. Uma sombra de dúvida paira sobre 15 anos de pesquisas.

Na verdade, esse estudo é como o menino do conto de Andersen que grita que o imperador está nu: em várias oportunidades, já se havia denunciado que algumas dessas ressonâncias carecem de base estatística e que estavam sendo supervalorizadas. “Isso já era sabido. Faz 20 anos que surgiram alertas sobre este problema. E, além disso, o trabalho nesse campo foi se desenvolvendo de forma cada vez mais solta, com os resultados que vemos agora”, lamenta Bryan Strange, diretor do departamento de neuroimagem da Fundação CIEN (Centro de Pesquisa de Doenças Neurológicas). Para Strange, o que o estudo denuncia “faz todo sentido” e “é muito bom que se alerte sobre esse perigo”.

“Em um certo sentido, isso pode mostrar que é um equívoco achar que existem soluções fáceis na ciência: conformar-se com o resultado sem saber como funciona o processo”, critica Canals

Santiago Canals, do Instituto de Neurociências, acha “surpreendente” que um pacote de software tão consagrado e popular possa conter um erro durante 15 anos sem que isso tenha sido detectado, como demonstra o estudo. Seu grupo utiliza um programa próprio, e ele alerta para o fato de que muitos cientistas se aproximaram do mundo da neuroimagem vindos de outros campos, sem conhecer bem o processo que estavam efetuando.

“Em um certo sentido, isso pode mostrar que é um equívoco acreditar que há soluções fáceis em ciência: conformar-se com o resultado sem saber como funciona o processo”, critica Canals, para quem os melhores grupos de pesquisa não estão em questão, mas apenas alguns trabalhos que se conformavam com resultados pouco consistentes estatisticamente falando.

Os dois especialistas concordam que, por trás desse problema, está um outro, mais geral, de toda a ciência: os estudos não estão sendo reproduzidos, ninguém está checando, tentando obter os mesmos resultados com os mesmos métodos, aquilo que outros cientistas publicam.

Strange está convencido, também, de que essa polêmica terá um impacto positivo. “Houve tanto barulho que os revisores [especialistas independentes que corrigem os estudos antes de eles serem publicados em revistas científicas específicas] ficarão ligados. Se deixaram passar, antes, estudos menos consistentes, agora deixarão de fazê-lo”, afirma. Apesar disso, ele acredita que não seria difícil identificar os trabalhos suspeitos: “Nós, que nos dedicamos a isso, podemos identificar com facilidade o rigor adotado ou não pelos autores na metodologia dos estudos”. E acrescenta: “Talvez devêssemos fazê-lo”.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.