“Precisamos da inteligência artificial para sobreviver como espécie”

Seis especialistas refletem sobre como voltar essa ferramenta para o nosso benefício

Armas autônomas capazes de atacar um alvo sem necessidade de intervenção humana; sistemas de análise de comportamentos capazes de influenciar o voto da sociedade; veículos sem motorista, vulneráveis a serem hackeados para causar um acidente. A inteligência artificial, além de representar uma grande oportunidade para a humanidade, traz consigo uma série de riscos. Como disse em 2017 o físico britânico Stephen Hawking, “pode ser o melhor ou o pior que já aconteceu à raça humana”. Os especialistas nesse campo preveem que haverá quem tente fazer um mau uso dessa ferramenta. Mas seria o caso de deixar de usar essa tecnologia por causa disso?

“Precisamos da inteligência artificial para sobreviver como espécie”, diz ao EL PAÍS Nuria Oliver, doutora em Inteligência Artificial pelo MIT e membro da Real Academia de Engenharia da Espanha. Sem ela, “não poderemos lidar com muitos dos grandes desafios que enfrentamos, como a mudança climática, o envelhecimento populacional, com a decorrente prevalência de doenças crônicas, e a disponibilidade limitada de recursos”.

Mais de 8.000 cientistas especializados em áreas tecnológicas – como o fundador da Tesla, Elon Musk, e o cofundador da Apple Steve Wozniak – assinaram em 2015 uma carta aberta alertando para os perigos da inteligência artificial. Devido a seu grande potencial, os especialistas argumentam que é importante investigar como aproveitar seus benefícios e evitar os riscos potenciais. Por isso, a Comissão Europeia nomeou neste ano um Comitê de Especialistas de Alto Nível em Inteligência Artificial, a fim de estudar as implicações éticas, legais e sociais dessa ferramenta.

“O perigo da inteligência artificial não é a singularidade tecnológica devido à existência de hipotéticas superinteligências artificiais. Os verdadeiros problemas já estão aqui”, afirma Ramón López de Mántaras. O diretor do Instituto de Pesquisas em Inteligência Artificial, ligado ao Conselho Superior de Pesquisa Científica da Espanha (CSIC, na sigla em espanhol), considera que esses riscos têm a ver com a privacidade, a autonomia, a excessiva confiança nas capacidades das máquinas, o viés dos algoritmos de aprendizagem e a impossibilidade de prestar contas e justificar suas decisões numa linguagem compreensível às pessoas.

Sonia Pacheco, diretora do congresso Digital Business World Congress, distingue entre um mau uso “não intencional” da inteligência artificial e o mau uso “com intenção”. O primeiro pode ocorrer quando um algoritmo é treinado com dados distorcidos e condicionados por nossos conhecimentos e preconceitos. A Amazon, por exemplo, começou a desenvolver em 2014 uma inteligência artificial de recrutamento que, baseando-se nos arquivos dos últimos 10 anos da companhia, aprendeu que os homens eram preferíveis, e por isso começou a discriminar as mulheres.

Dilemas éticos

“As decisões algorítmicas baseadas em dados têm o potencial de melhorar nossa tomada de decisões”, sustenta Oliver. Mas quando essas decisões afetam milhares ou milhões de pessoas, “surgem dilemas éticos importantes”: “Como podemos garantir que tais decisões e ações não têm consequências negativas para as pessoas? Quem é o responsável por essas decisões? O que acontecerá quando um algoritmo conhecer a cada um de nós melhor do que nós mesmos, e for capaz de aproveitar esse conhecimento para manipular nosso comportamento de maneira subliminar?”.

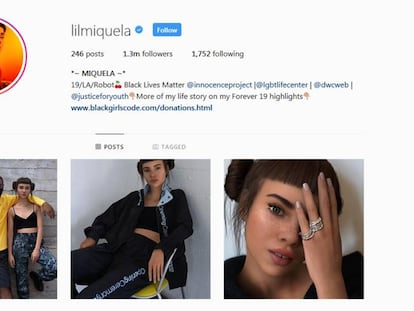

Um mau uso “intencional” da inteligência artificial poderia acarretar riscos físicos, políticos ou de segurança, segundo Pacheco. Um carro autônomo, por exemplo, poderia ser hackeado para se envolver num acidente ou ser usado como uma arma; as fake news podem “encher de ruído as redes sociais com o objetivo de manipular de maneira dirigida grupos de usuários selecionados”; e “sistemas maliciosos poderiam replicar nossa voz, gerando informação falsa, ou gerar imagens de nós que fossem irreais graças a técnicas de regeneração de imagem”.

Jeff Bezos, fundador e executivo-chefe da Amazon, disse em abril, num evento do Fórum de Liderança do Centro Presidencial George W. Bush, que é “muito mais provável que a inteligência artificial nos ajude” do que atrapalhe. Mas admitiu os perigos envolvidos: “As armas autônomas são extremamente aterradoras”, disse.

O maior risco, segundo Oliver, “não está nos robôs físicos, e sim em sistemas de software de grande escala que podem afetar milhões de pessoas em pouquíssimo tempo”. “Para minimizar o risco de que estes sistemas possam ser hackeados”, prossegue a doutora em Inteligência Artificial pelo MIT, “é fundamental tomar medidas de segurança, fiabilidade, reprodutibilidade, prudência e veracidade”.

O papel das companhias tecnológicas

Para Francesca Rossi, diretora de Ética em Inteligência Artificial da IBM, é importante que as companhias tecnológicas apostem num desenvolvimento dessa ferramenta com o propósito de aumentar a inteligência humana em vez de substituí-la. Também considera fundamental que exista um diálogo construtivo no qual participem “desde aqueles que se encontram na primeira linha da investigação em inteligência artificial até aqueles que representam os setores mais vulneráveis da sociedade”. Rossi, aliás, participa do Comitê de Especialistas de Alto Nível em Inteligência Artificial da Comissão Europeia, que está formado não só por especialistas em tecnologia, mas também por filósofos, psicólogos, sociólogos e economistas.

A inteligência artificial é transversal e pode ser aplicada em diferentes campos: da biologia, física, medicina e química a educação, sistemas de produção, logística e transporte. Todos os especialistas consultados concordam que não se deve abrir mão de utilizá-la. “É uma questão de usá-la adequadamente e pôr os controles necessários para evitar seu uso com fins perversos”, afirma Jose María Lucía, sócio responsável pelo Centro de Inteligência Artificial e Análise de Dados do EY Wavespace. Para detectar um problema e adotar qualquer solução é preciso responder algumas pergunta: “Como vamos detectar se algo está saindo do normal? O que fazer se isso ocorrer?”. Lucía explica, por exemplo, que “houve vários casos no mundo das Bolsas em que os algoritmos de investimento acabaram criando o caos quando diante de cenários inesperados”.

Algumas empresas tecnológicas já estabeleceram princípios básicos para desenvolver a inteligência artificial de forma ética. David Carmona, diretor geral de Desenvolvimento de Negócios em Inteligência Artificial da Microsoft Corporation, explica que sua companhia se baseia em seis princípios básicos: “Equanimidade, para nos assegurar de que os algoritmos não tenham um viés; fiabilidade, para garantir essa confiança tecnológica; privacidade; transparência sobre o uso de dados e funcionamento; inclusão de todas as pessoas; e responsabilidade da empresa que está por trás desses processos”.

O fato de a inteligência artificial existir não quer dizer que necessariamente será feito um mau uso dela, salientam os especialistas consultados. “Da mesma maneira como há códigos éticos definidos praticamente em nível internacional nos campos da biomedicina e em outros âmbitos da pesquisa científica, deverão ser estabelecidas algumas bases: um código de conduta, normais e critérios éticos e uma estrutura regulatória que impeçam um mau uso”, conclui Pacheco.