Google conserta seu algoritmo “racista” apagando os gorilas

Google Photos confundia pessoas negras com macacos. Este patch mostra a opacidade dos algoritmos

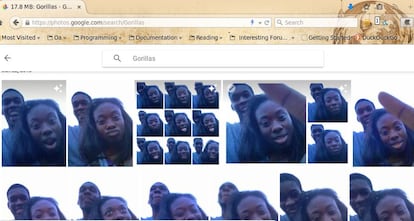

Em junho de 2015, um usuário do Google Photos descobriu que o programa etiquetava seus amigos negros como gorilas. A inteligência artificial do Google não era capaz de distinguir a pele de um ser humano da dos macacos, como gorilas e chimpanzés. Esse viés racista da máquina forçou o Google a pedir desculpas e prometeu encontrar uma solução para o erro. Dois anos depois, a solução é clara: para que o programa não confunda seres humanos com gorilas, tirou os gorilas do buscador. E os chimpanzés. E os macacos.

A revista Wired fez o teste, alimentando a máquina com milhares de fotos, incluindo de grandes símios e outras espécies de macacos. O programa – criado para classificar sozinho as fotos dos usuários usando inteligência artificial – responde perfeitamente quando você pede que encontre orangotangos, gibões, babuínos ou saguis, encontrando-os sem problemas. Mas não responde quando você pede “macacos”, “gorilas” e “chimpanzés”, mesmo que tenha algumas fotos guardadas. O patch do Google é fazer desaparecer estes animais do léxico deste aplicativo para a gestão de fotos pessoais (não no buscador de imagens). O programa também sabe buscar “homem negro” ou “mulher negra”.

A forma de resolver o problema é apagar o problema: autocensurar essas etiquetas. “A tecnologia de etiquetar imagens ainda é jovem e, infelizmente, não é perfeita”, respondeu um porta-voz do Google, admitindo o patch. O Flickr teve um problema semelhante, ao etiquetar negros como macacos. O algoritmo do Facebook permite diferenciar os usuários por raça. Esses subprodutos inesperados estão em toda parte.

“Aqueles que estão em grupos historicamente marginalizados – mulheres, não brancos e menos educados – são os mais temerosos da tecnologia”, diz um estudo

Este episódio é um exemplo perfeito de alguns dos problemas que estão sendo descobertos no campo da inteligência artificial. Por exemplo, que os algoritmos herdam vieses e preconceitos presentes nas bases de dados (alimentadas por seres humanos) e nas mãos dos programadores que os desenvolvem. Os inovadores, os inventores, tendem a ser homens brancos de boa família, e isso de alguma forma acaba aparecendo no fruto do seu trabalho.

Também mostra que a tecnologia que permite que as máquinas façam reconhecimento visual é muito mais difícil de aperfeiçoar do que acreditamos. É possível que em breve tenhamos carros automáticos circulando pelas ruas, tomando decisões difíceis como quem devem atropelar. Em caso de dúvida, o que vai acontecer se é difícil para as máquinas distinguirem um animal de uma pessoa? Vai escolher salvar a pessoa com pele mais clara e atropelar a de pele mais escura porque pode ser um macaco? “É muito difícil modelar tudo que seu sistema verá quando estiver ao vivo”, reconhece Vicente Ordóñez Román, professor da Universidade da Virgínia, na Wired.

Este incidente ilustra um problema maior: as máquinas acabam sendo uma caixa-preta, opaca e cheia de segredos, mesmo para seus próprios desenvolvedores

Além disso, este incidente ilustra um problema maior, que já foi alertado por especialistas em inteligência artificial: as máquinas acabam sendo uma caixa-preta, opaca e cheia de segredos, até para seus próprios desenvolvedores. O programador sabe com quais elementos alimentou o algoritmo e sabe quais são os resultados, mas não conhece em detalhes os processos que ocorrem dentro do cérebro de silício. Quando algo dá errado, como neste caso, não sabem exatamente o motivo nem podem resolver diretamente o problema, porque não sabem onde está. “Podemos construir esses modelos, mas não sabemos como funcionam”, reconhecia um especialista em diagnóstico de doenças usando inteligência artificial.

“A tomada de decisões automatizada pode significar riscos significativos para os direitos e liberdades das pessoas que necessitam de garantias apropriadas”, advertiu um relatório da AI Now, um instituto dedicado à investigação sobre os problemas decorrentes do uso da inteligência artificial. Esse relatório criticava a opacidade com a qual essas caixas-pretas são operadas. Em alguns casos, opacas para seus criadores e, no geral opacas para a sociedade que é afetada por suas decisões: finanças, saúde, seguros, mercado de trabalho, decisões judiciais... Todos são afetados por decisões algorítmicas.

Um estudo recente sobre a percepção social dos robôs mostrava uma conclusão interessante neste contexto: “Aqueles que estão em grupos historicamente marginalizados – mulheres, não brancos e menos educados – são os mais temerosos da tecnologia”. Certamente não é por acaso.

Tu suscripción se está usando en otro dispositivo

¿Quieres añadir otro usuario a tu suscripción?

Si continúas leyendo en este dispositivo, no se podrá leer en el otro.

FlechaTu suscripción se está usando en otro dispositivo y solo puedes acceder a EL PAÍS desde un dispositivo a la vez.

Si quieres compartir tu cuenta, cambia tu suscripción a la modalidad Premium, así podrás añadir otro usuario. Cada uno accederá con su propia cuenta de email, lo que os permitirá personalizar vuestra experiencia en EL PAÍS.

¿Tienes una suscripción de empresa? Accede aquí para contratar más cuentas.

En el caso de no saber quién está usando tu cuenta, te recomendamos cambiar tu contraseña aquí.

Si decides continuar compartiendo tu cuenta, este mensaje se mostrará en tu dispositivo y en el de la otra persona que está usando tu cuenta de forma indefinida, afectando a tu experiencia de lectura. Puedes consultar aquí los términos y condiciones de la suscripción digital.